In einer zunehmend digitalisierten Welt ist das Management von Kundenbeziehungen entscheidend für den Unternehmenserfolg, besonders im E-Commerce. CRM-Systeme wie Salesforce ermöglichen es, Kundenbeziehungen zu pflegen, zu analysieren und strategisch zu nutzen. Salesforce hat sich durch kontinuierliche Weiterentwicklung als führende CRM-Plattform etabliert. Mit der Einführung von Salesforce Lightning, das Salesforce Classic ersetzt, können Unternehmen ihre Geschäftsprozesse effizienter gestalten und ihre Produktivität steigern.

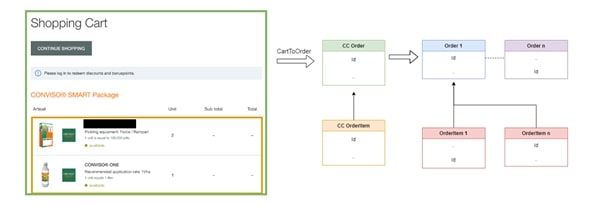

Diese Arbeit konzentriert sich auf die Migration eines Teils der Daten von Salesforce Classic zu Salesforce Lightning, am Beispiel eines Saatgut-Onlineshops. Die Migration von Salesforce B2B-Commerce zu Salesforce B2B-Lightning ist komplex und erfordert sorgfältige Planung und Umsetzung. Ziel ist die Erstellung eines Datenmigrationskonzepts, das speziell auf die Bedürfnisse des Saatgut-Shops zugeschnitten ist. Ein Vorteil ist der Zugriff auf alte Kundendaten im neuen System, wodurch neue CRM-Funktionen genutzt und wichtige Daten bewahrt werden. Entwickler können diese Arbeit als Grundlage für ähnliche Projekte nutzen.

Die Migration verbessert die Anpassung an spezifische Geschäftsbedürfnisse, steigert die Prozesseffizienz und schafft eine bessere Plattform für zukünftiges Wachstum. Der Onlineshop kann dynamisch auf Marktänderungen und neue Geschäftsanforderungen reagieren, was einen wesentlichen strategischen Vorteil darstellt.